Многим геймерам кажется, что производительность видеокарт зависит от самых простых переменных, включая шину памяти, количество видеопамяти и теоретическую мощность. Судя по тому, что мы видим сегодня, это не так. Несколько простых примеров: GeForce RTX 3050 выдаёт примерно аналогичное количество кадров в секунду с GeForce RTX 2060, а последняя в свою очередь очень близка к GeForce GTX 1660 Super. Сравниваем некоторые характеристики: 8 Гб и 128-битная шина на первой против 6 Гб и 192-битная шина на второй и третьей. Но есть ещё и GeForce RTX 3060 Ti, получившая 8 Гб видеопамяти, тогда как менее скоростная GeForce RTX 3060 имеет все 12 Гб. Сюда же прибавьте высокую производительность серии Radeon RX 6000, несмотря на отставание по ширине шины от конкурентов.

Проще говоря, и количество видеопамяти и ширина шины важны для конечной производительности, но есть куда более важные переменные. Кто-то в пример приводит количество ядер CUDA или шейдерных ядер, но и здесь есть нестыковки. Например, в противостоянии GeForce RTX 3080 Ti и Radeon RX 6900 ХТ побеждает первая, предлагая 8960 против 5120 условных единиц измерения. А между тем этим видеокарты примерно равны по скорости даже несмотря на разницу в шине памяти (384 бита против 256 бит в пользу NVIDIA). А значит на первое место по влиянию на конечную производительность выходят архитектурные улучшения. И вот именно в этом аспекте есть смысл изучить данные последней утечки, в рамках которой нам вещают о невероятной скорости GeForce RTX 4070 Ti, которая в реальных задачах окажется быстрее GeForce RTX 3090 Ti. На первый взгляд такое кажется невозможным, а технические характеристики только подтверждают наши сомнения.

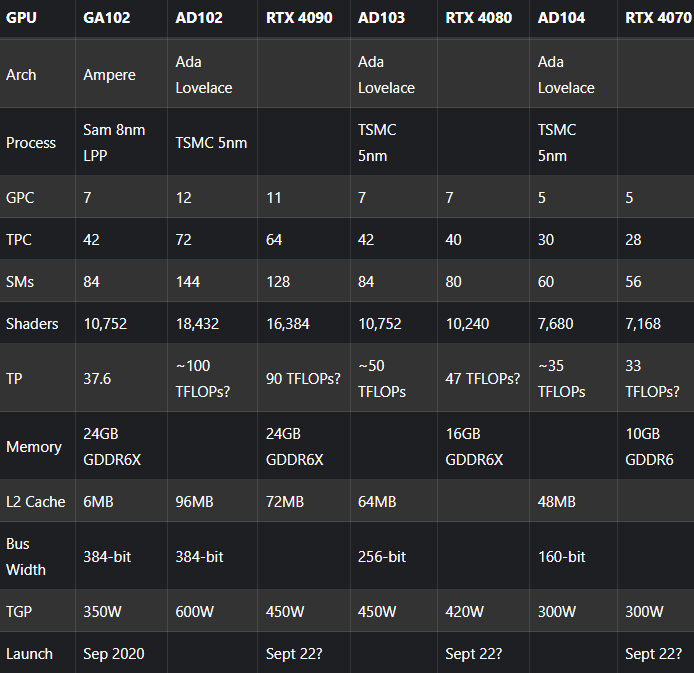

- GeForce RTX 3090 Ti: 24 Гб видеопамяти на скорости 21 Гбит/с и 384-битной шине, 10 752 ядра CUDA и 37.6 TFLOP теоретической производительности.

- GeForce RTX 4070 Ti: 10 Гб на скорости 18 Гбит/с на 160-битной шине, 7 168 ядер CUDA и 33 TFLOP теоретической производительности.

Ну и как в этом случае вторая может конкурировать с первой? По мнению экспертов, в 2022 году мы станем свидетелями сразу двух больших прорывов. Во-первых, двукратное улучшение технологического процесса. Известно, что сегодня серия GeForce RTX 3000 выпускается по 8-нм нормам Samsung. Вообще злые языки утверждают, что этот технологический процесс соответствует 10-нм от TSMC, тогда как в следующем поколении нас ждёт переход на 5 нанометров. Учитывайте, что перед нами ещё более улучшенная версия этого технологического процесса, а значит есть все основания говорить о действительно мощном рывке. Во-вторых, архитектура Ada Lovelace остаётся тёмной лошадкой. Независимые эксперты пока не получили к ней доступа, но в сети уже гуляют результаты игровых и синтетических тестов.

Чисто теоретически, GeForce RTX 4070 Ti может оказаться быстрой, вот только в тестах мы видели GeForce RTX 4090, которая демонстрирует двукратный прирост. Если обратиться к указанной выше таблице, то флагман получит невероятные 16 384 ядра CUDA и до 90 TFLOP теоретической мощности. А ведь ещё есть 384-битная шина и 24 Гб видеопамяти. По сравнению со скромной GeForce RTX 4070 Ti – это должно давать чуть ли не трёхкратный прирост производительности. Даже если не углубляться в детали, то становится очевидным игнорирование законов физики, ведь разница между графическими чипами слишком велика, чтобы столь смелые прогнозы могли оказаться верны. Нам кажется, что инсайдеры запутались в своих прогнозах. Слишком мало конкретики, а большая часть – это утечки месячной давности, которые муссируются, поднимая информационный шум во всех технических ресурсах. А вообще проблема не в приросте производительности. С нашей точки зрения, сегодня нет нехватки чистой мощности, тогда как с ценами всё очень плохо. Было бы куда лучше сосредоточить свои усилия на снижении стоимости нового поколения, что позволило бы AMD или NVIDIA заработать действительно большие деньги.