Исследования в области машинного обучения развиваются все более быстрыми темпами. Вероятно, до достижения сингулярности еще несколько десятков лет, но ИИ уже стал модным словечком, которым пользуется каждая технологическая компания. Существует бесчисленное множество моделей ИИ, но многие из них полагаются на аналогичные методы обучения для развития и совершенствования своих возможностей.

Обучение с подкреплением в широком смысле описывает методы, в которых используются вознаграждения и штрафы для управления моделью ИИ при выполнении сложной задачи. Человеческой аналогией может быть игра в любую игру с рейтинговой системой. Победа в играх вознаграждается продвижением вверх в таблице лидеров, а ошибки сопровождаются понижением рейтинга. В процессе обучения игроки будут пробовать разные тактики и стратегии, чтобы приспособиться к тому, что делают противники. Конечно, некоторые люди могут не заботиться о ранге в иерархии, но модели ИИ могут быть принуждены программным обеспечением.

AlphaTensor - это модель искусственного интеллекта, основанная на AlphaZero, перед которой стоит задача обнаружения алгоритмов для решения произвольных задач умножения матриц. Умножения матриц используются для описания преобразований в пространстве, а матрицы представляют математическую концепцию, называемую тензором, общим термином для скаляров и векторов. Тензорная математика лежит в основе линейной алгебры и имеет применение в различных областях, от материаловедения до самого машинного обучения.

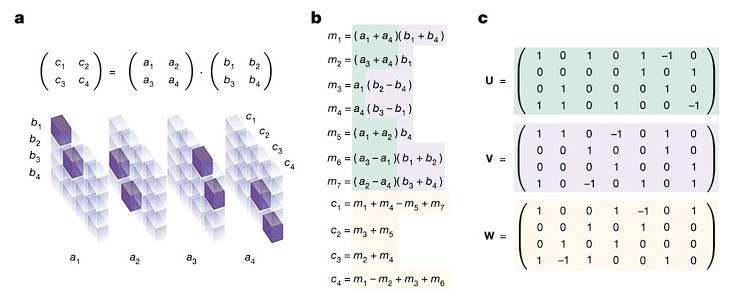

Матричные умножения решаются в соответствии с определенными правилами и процессами. Как и в большей части математики, существуют оптимизации, позволяющие решать эти задачи за меньшее количество шагов. Усовершенствованные алгоритмы позволяют выполнять умножение больших матриц в допустимых временных масштабах.

Пример умножения двух матриц 2x2

AlphaTensor представлена игрой в виде одиночной головоломки. Доска состоит из сетки чисел, представляющих 3D-тензор, который AlphaTensor затем должен свести к нулю с помощью серии допустимых ходов, состоящих из матричных умножений. Возможный набор ходов ошеломляюще огромен, превосходя такие игры, как шахматы и го, по нескольким параметрам.

ИИ использует поиск по дереву Монте-Карло (MCTS) для планирования своих действий. По сути, это та же система, которую AlphaZero использует для освоения шахмат и го. В MCTS ИИ-игрок просматривает выборку потенциальных ходов, результаты которых отслеживаются как распределение потенциального успеха. Раунды игры ограничены определенным количеством запусков, чтобы избежать излишне длинных игр, но успешные матчи переигрываются для улучшения параметров принятия решений в сети.

Соавтор Хусейн Фавзи рассказал Nature: "AlphaTensor не встраивает человеческую интуицию в отношении матричного умножения", поэтому "ИИ в некотором смысле должен создавать свои собственные знания о проблеме с нуля". Благодаря этой обратной связи AlphaTensor узнает, какие шаги с большей вероятностью принесут успех. При размерах матриц до 5 x 5 пар AlphaTensor соответствует или превосходит эффективность известных алгоритмов с точки зрения количества шагов.

В частности, AlphaTensor обнаружил 47-шаговое решение парного матричного умножения 4 x 4, которое улучшает известное 49-шаговое решение, найденное в 1969 году. Он также сократил на пару шагов парное матричное умножение 5 x 5, сократив 98 шагов до 96.

Исследователи отмечают, что первоначальная предопределенная выборка наборов движений действительно имеет ограничения. Возможно, что более эффективные алгоритмы могли бы быть получены из исходных ходов, которые были исключены в начале. Помимо перебора всех возможных ходов, что требует значительных вычислительных ресурсов, исследователи считают, что они могут адаптировать AlphaTensor для поиска лучших стартовых наборов.

В действительности, однако, легко провести параллели между AlphaTensor, который учится решать эти огромные проблемы, и начинающим игроком в Starcraft, в котором ИИ DeepMind по совпадению также преуспел. Путем итерации он узнает, какие ходы максимизируют его шансы на успех, а какие с большей вероятностью закончатся неудачей - например, когда рой зерглингов поджаривается группой огнедышащих летучих мышей противника. В будущих матчах игрок за зерга может попытаться незаметно пробежать мимо, чтобы воспользоваться отсутствием мобильности адской летучей мыши, а не вступать в прямой бой. Умножение матриц может быть не таким захватывающим, но основной процесс, который ИИ использует для обучения, все тот же.